NLP:不要重新造輪子

作者|Abhijit Gupta 編譯|VK 來源|Towards Data Science

介紹

自然語言處理(NLP)是一個令人生畏的領域名稱。從非結構化文字中生成有用的結論是很困難的,而且有無數的技術和演演算法,每一種都有自己的用例和複雜性。作為一個接觸NLP最少的開發人員,很難知道要使用哪些方法以及如何實現它們。

如果我以最小的努力提供儘量完美的結果。使用80/20原則,我將向你展示如何在不顯著犧牲結果(80%)的情況下快速(20%)交付解決方案。

「80/20原則認為,少數的原因、投入或努力通常導致大多數結果、產出或回報」

-理查德·科赫,80/20原則的作者

我們將如何實現這一目標?有一些很棒的Python庫!我們可能站在巨人的肩膀上,迅速創新,而不是重新發明輪子。通過預先測試的實現和預訓練的模型,我們將專注於應用這些方法並創造價值。

本文的目標讀者是希望將自然語言處理快速整合到他們的專案中的開發人員。在強調易用性和快速效果的同時,效能也會下降。根據我的經驗,80%的技術對於專案來說是足夠的,但是也可以從其他地方尋找相關方法

不用多說了,我們開始吧!

什麼是NLP?

自然語言處理是語言學、電腦科學和人工智慧的一個分支領域,允許通過軟體自動處理文字。NLP使機器能夠閱讀、理解和響應雜亂無章的非結構化文字。

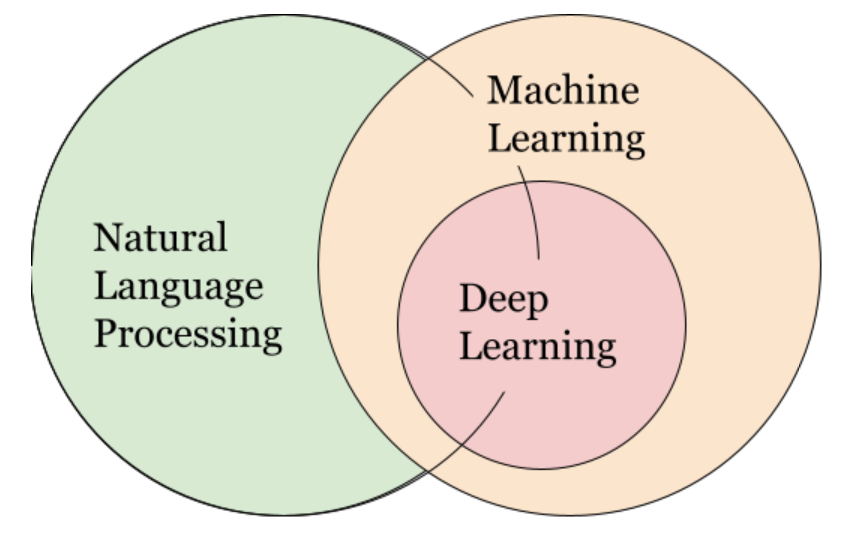

人們通常將NLP視為機器學習的一個子集,但實際情況更為微妙。

有些NLP工具依賴於機器學習,有些甚至使用深度學習。然而,這些方法往往依賴於巨量資料集,並且難以實現。相反,我們將專注於更簡單、基於規則的方法來加快開發週期。

術語

從最小的資料單位開始,字元是單個字母、數位或標點符號。一個單詞是一個字元列表,一個句子是一個單詞列表。檔案是句子的列表,而語料庫是檔案的列表。

預處理

預處理可能是NLP專案中最重要的一步,它涉及到清理輸入,這樣模型就可以忽略噪聲,並將注意力集中在最重要的內容上。一個強大的預處理管道將提高所有模型的效能,所以必須強調它的價值。

以下是一些常見的預處理步驟:

- 分段:給定一長串字元,我們可以用空格分隔檔案,按句點分隔句子,按空格分隔單詞。實現細節將因資料集而異。

- 使用小寫:大寫通常不會增加效能,並且會使字串比較更加困難。所以把所有的東西都改成小寫。

- 刪除標點:我們可能需要刪除逗號、引號和其他不增加意義的標點。

- 刪除停用詞:停用詞是像「she」、「the」和「of」這樣的詞,它們不會增加文字的含義,並且分散對關鍵字的注意力。

- 刪除其他不相關單詞:根據你的應用程式,你可能希望刪除某些不相關的單詞。例如,如果評估課程回顧,像「教授」和「課程」這樣的詞可能沒有用。

- 詞幹/詞根化:詞幹分析和詞根化都會生成詞形變化單詞的詞根形式(例如:「running」到「run」)。詞幹提取速度更快,但不能保證詞根是英語單詞。詞根化使用語料庫來確保詞根是一個單詞,但代價是速度。

- 詞性標註:詞性標註以詞性(名詞、動詞、介詞)為依據,根據詞義和語境來標記單詞。例如,我們可以專注於名詞進行關鍵字提取。

有關這些概念的更全面的介紹,請檢視以下指南:

這些步驟是成功的預處理的基礎。根據資料集和任務的不同,你可以跳過某些步驟或新增新步驟。通過預處理手動觀察資料,並在出現問題時進行更正。

Python庫

讓我們來看看NLP的兩個主要Python庫。這些工具將在預處理期間,佔據非常大的作用

NLTK

自然語言工具包是Python中使用最廣泛的NLP庫。NLTK是UPenn為學術目的而開發的,它有大量的特徵和語料庫。NLTK非常適合處理資料和執行預處理:https://www.nltk.org/

NLTK是構建Python程式以處理人類語言資料的領先平臺。它提供了易於使用的API

>>> import nltk

>>> sentence = "At eight o'clock on Thursday morning Arthur didn't feel very good."

>>> tokens = nltk.word_tokenize(sentence)

>>> tokens

['At', 'eight', "o'clock", 'on', 'Thursday', 'morning', 'Arthur', 'did', "n't", 'feel', 'very', 'good', '.']

>>> tagged = nltk.pos_tag(tokens)

>>> tagged[0:6]

[('At', 'IN'), ('eight', 'CD'), ("o'clock", 'JJ'), ('or', 'IN'), ('Thursday', 'NNP'), ('morning', 'NN')]這是NLTK網站上的一個例子,它展示了標記句子和標記詞性是多麼簡單。

SpaCy

SpaCy是一個現代的的庫。雖然NLTK對每個特性都有多個實現,但是SpaCy保留效能最好的實現。Spacy支援多種功能,有關詳細資訊,請閱讀檔案:https://spacy.io/

只需幾行程式碼,我們就可以使用SpaCy執行命名實體識別。使用SpaCy api可以快速完成許多其他任務。

import spacy

nlp = spacy.load("en_core_web_sm")

text = ("When Sebastian Thrun started working on self-driving cars at "

"Google in 2007, few people outside of the company took him seriously")

doc = nlp(text)

for entity in doc.ents:

print(entity.text, entity.label_)

# 輸出

# Sebastian Thrun

# 谷歌組織

# 2007日期GenSim

與NLTK和SpaCy不同,GenSim專門解決資訊檢索(IR)問題。GenSim的開發重點是記憶體管理,它包含許多檔案相似性模型,包括Latent Semantic Indexing、Word2Vec和FastText:https://github.com/RaRe-Technologies/gensim

Gensim是一個Python庫,用於主題模型、檔案索引和大型語料庫的相似性檢索:https://github.com/RaRe-Technologies/gensim

下面是一個預先訓練的GenSim Word2Vec模型的例子,它可以發現單詞的相似性。不用擔心那些雜亂無章的細節,我們可以很快得到結果。

import gensim.downloader as api

wv = api.load("word2vec-google-news-300")

pairs = [

('car', 'minivan'), # 小型貨車是一種汽車

('car', 'bicycle'), # 也是有輪子的交通工具

('car', 'airplane'), # 沒有輪子,但仍然是交通工具

('car', 'cereal'), # ... 等等

('car', 'communism'),

]

for w1, w2 in pairs:

print('%r\t%r\t%.2f % (w1, w2, wv.similarity(w1, w2)))

# 輸出

# 'car' 'minivan' 0.69

# 'car' 'bicycle' 0.54

# 'car' 'airplane' 0.42

# 'car' 'cereal' 0.14

# 'car' 'communism' 0.06還有更多…

這個列表並不全面,但涵蓋了一些用例。我建議檢查這個儲存庫以獲取更多的工具和參考:https://github.com/keon/awesome-nlp

應用

既然我們已經討論了預處理方法和Python庫,讓我們用幾個例子把它們放在一起。對於每種演演算法,我將介紹幾個NLP演演算法,根據我們的快速開發目標選擇一個,並使用其中一個庫建立一個簡單的實現。

應用1:預處理

預處理是任何NLP解決方案的關鍵部分,所以讓我們看看如何使用Python庫來加快處理速度。根據我的經驗,NLTK擁有我們所需的所有工具,並針對獨特的用例進行客製化。讓我們載入一個樣本語料庫:

import nltk

# 載入brown語料庫

corpus = nltk.corpus.brown

# 存取語料庫的檔案

print(corpus.fileids())

# 輸出

['ca01', 'ca02', 'ca03', 'ca04', 'ca05', 'ca06', 'ca07', 'ca08', 'ca09', 'ca10', 'ca11', 'ca12', 'ca13', 'ca14', 'ca15', 'ca16',

'ca17', 'ca18', 'ca19', 'ca20', 'ca21', 'ca22', 'ca23', 'ca24', 'ca25', 'ca26', 'ca27', 'ca28', 'ca29', 'ca30', 'ca31', 'ca32',

'ca33', 'ca34', 'ca35', 'ca36', 'ca37', 'ca38', 'ca39', 'ca40', 'ca41', 'ca42', 'ca43', 'ca44', 'cb01', 'cb02', 'cb03', 'c...按照上面定義的管道,我們可以使用NLTK來實現分段、刪除標點和停用詞、執行詞幹化等等。看看刪除停用詞是多麼容易:

from nltk.corpus import stopwords

sw = stopwords.words("english")

sw += "" # 空字串

def remove_sw(doc):

sentences = []

for sentence in doc:

sentence = [word for word in sentence if word not in sw]

sentences.append(sentence)

return sentences

print("With Stopwords")

print(doc1[1])

print()

doc1 = remove_sw(doc1)

print("Without Stopwords")

print(doc1[1])

# 輸出

# 有停用詞

# ['the', 'jury', 'further', 'said', 'in', 'presentments', 'that', 'the', 'city', 'executive', 'committee', 'which', 'had',

# 'charge', 'of', 'the', 'election', 'deserves', 'the', 'praise', 'and', 'thanks', 'of', 'the', 'city', 'of', 'atlanta', 'for',

# 'the', 'manner', 'in', 'which', 'the', 'election', 'was', 'conducted']

# 沒有停用詞

# ['jury', 'said', 'presentments', 'city', 'executive', 'committee', 'charge', 'election', 'deserves', 'praise', 'thanks', 'city',

# 'atlanta', 'manner', 'election', 'conducted']整個預處理管道佔用了我不到40行Python。請參閱此處的完整程式碼。記住,這是一個通用的範例,你應該根據你的特定用例的需要修改流程。

應用2:檔案聚類

檔案聚類是自然語言處理中的一個常見任務,所以讓我們來討論一些方法。這裡的基本思想是為每個檔案分配一個表示所討論主題的向量:

如果向量是二維的,我們可以像上面一樣視覺化檔案。在這個例子中,我們看到檔案A和B是緊密相關的,而D和F是鬆散相關的。即使這些向量是3維、100維或1000維,使用距離度量的話,我們也可以計算相似性。

下一個問題是如何使用非結構化文字輸入為每個檔案構造這些向量。這裡有幾個選項,從最簡單到最複雜的:

詞袋:為每個唯一的單詞分配一個索引。給定檔案的向量是每個單詞出現的頻率。

TF-IDF:根據單詞在其他檔案中的常見程度來加強表示。如果兩個檔案共用一個稀有單詞,則它們比共用一個公共單詞更相似。

潛在語意索引(LSI):詞袋和TF-IDF可以建立高維向量,這使得距離測量的準確性降低。LSI將這些向量壓縮到更易於管理的大小,同時最大限度地減少資訊損失。

Word2Vec:使用神經網路,從大型文字語料庫中學習單詞的關聯關係。然後將每個單詞的向量相加得到一個檔案向量。

Doc2Vec:在Word2Vec的基礎上構建,但是使用更好的方法從單詞向量列表中近似檔案向量。

Word2Vec和Doc2Vec非常複雜,需要大量的資料集來學習單詞嵌入。我們可以使用預訓練過的模型,但它們可能無法很好地適應領域內的任務。相反,我們將使用詞袋、TF-IDF和LSI。

現在選擇我們的庫。GenSim是專門為這個任務而構建的,它包含所有三種演演算法的簡單實現,所以讓我們使用GenSim。

對於這個例子,讓我們再次使用Brown語料庫。它有15個文字類別的檔案,如「冒險」、「編輯」、「新聞」等。在執行我們的NLTK預處理例程之後,我們可以開始應用GenSim模型。

首先,我們建立一個將標識對映到唯一索引的字典。

from gensim import corpora, models, similarities

dictionary = corpora.Dictionary(corpus)

dictionary.filter_n_most_frequent(1) # removes ""

num_words = len(dictionary)

print(dictionary)

print()

print("Most Frequent Words")

top10 = sorted(dictionary.cfs.items(), key=lambda x: x[1], reverse=True)[:10]

for i, (id, freq) in enumerate(top10):

print(i, freq, dictionary[id])

# 輸出

# Dictionary(33663 unique tokens: ['1', '10', '125', '15th', '16']...)

# 頻率最高的詞

# 0 3473 one

# 1 2843 would

# 2 2778 say

# 3 2327 make

# 4 1916 time

# 5 1816 go

# 6 1777 could

# 7 1665 new

# 8 1659 year

# 9 1575 take接下來,我們迭代地應用詞袋、TF-IDF和潛在語意索引:

corpus_bow = [dictionary.doc2bow(doc) for doc in corpus]

print(len(corpus_bow[0]))

print(corpus_bow[0][:20])

# 輸出

# 6106

# [(0, 1), (1, 3), (2, 1), (3, 1), (4, 1), (5, 1), (6, 1), (7, 1), (8, 1), (9, 2), (10, 1), (11, 1), (12, 2), (13, 2), (14, 2), (15,

# 1), (16, 2), (17, 2), (18, 3), (19, 1)]

tfidf_model = models.TfidfModel(corpus_bow)

corpus_tfidf = tfidf_model[corpus_bow]

print(len(corpus_tfidf[0]))

print(corpus_tfidf[0][:20])

# 輸出

# 5575

# [(0, 0.001040495879718581), (1, 0.0011016669638018743), (2, 0.002351365659027428), (3, 0.002351365659027428), (4,

# 0.0013108697793088472), (5, 0.005170600993729588), (6, 0.003391861538746009), (7, 0.004130105114011007), (8,

# 0.003391861538746009), (9, 0.008260210228022013), (10, 0.004130105114011007), (11, 0.001955787484706956), (12,

# 0.0015918258736505996), (13, 0.0015918258736505996), (14, 0.008260210228022013), (15, 0.0013108697793088472), (16,

# 0.0011452524080876978), (17, 0.002080991759437162), (18, 0.004839366251287288), (19, 0.0013108697793088472)]

lsi_model = models.LsiModel(corpus_tfidf, id2word=dictionary, num_topics=20)

corpus_lsi = lsi_model[corpus_tfidf]

print(len(corpus_lsi[0]))

print(corpus_lsi[0])

# 輸出

# 15

# [(0, 0.18682238167974372), (1, -0.4437583954806601), (2, 0.22275580411969662), (3, 0.06534575527078117), (4,

# -0.10021080420155845), (5, 0.06653745783577146), (6, 0.05025291839076259), (7, 0.7117552624193217), (8, -0.3768886513901333), (9,

# 0.1650380936828472), (10, 0.13664364557932132), (11, -0.03947144082104315), (12, -0.03177275640769521), (13,

# -0.00890543444745628), (14, -0.009715808633565214)]在大約10行Python程式碼中,我們處理了三個獨立的模型,併為檔案提取了向量表示。利用餘弦相似度進行向量比較,可以找到最相似的檔案。

categories = ["adventure", "belles_lettres", "editorial", "fiction", "government",

"hobbies", "humor", "learned", "lore", "mystery", "news", "religion",

"reviews", "romance", "science_fiction"]

num_categories = len(categories)

for i in range(3):

print(categories[i])

sims = index[lsi_model[corpus_bow[i]]]

top3 = sorted(enumerate(sims), key=lambda x: x[1], reverse=True,)[1:4]

for j, score in top3:

print(score, categories[j])

print()

# 輸出

# adventure

# 0.22929086 fiction

# 0.20346783 romance

# 0.19324714 mystery

# belles_lettres

# 0.3659389 editorial

# 0.3413822 lore

# 0.33065677 news

# editorial

# 0.45590898 news

# 0.38146105 government

# 0.2897901 belles_lettres就這樣,我們有結果了!冒險小說和浪漫小說最為相似,而社論則類似於新聞和政府。在這裡檢視完整的程式碼:https://github.com/avgupta456/medium_nlp/blob/master/Similarity.ipynb。

應用3:情感分析

情感分析是將非結構化文字解釋為正面、負面或中性。情感分析是分析評論、衡量品牌、構建人工智慧聊天機器人等的有用工具。

與檔案聚類不同,在情感分析中,我們不使用預處理。段落的標點符號、流程和上下文可以揭示很多關於情緒的資訊,所以我們不想刪除它們。

為了簡單有效,我建議使用基於模式的情感分析。通過搜尋特定的關鍵詞、句子結構和標點符號,這些模型測量文字的積極消極性。以下是兩個帶有內建情感分析器的庫:

VADER 情感分析:

VADER 是 Valence Aware Dictionary and sEntiment Recognizer的縮寫,是NLTK用於情感分析的擴充套件。它使用模式來計算情緒,尤其適用於表情符號和簡訊俚語。它也非常容易實現。

from vaderSentiment.vaderSentiment import SentimentIntensityAnalyzer

analyzer = SentimentIntensityAnalyzer()

print(analyzer.polarity_scores("This class is my favorite!!!"))

print(analyzer.polarity_scores("I hate this class :("))

# 輸出

# {'neg': 0.0, 'neu': 0.508, 'pos': 0.492, 'compound': 0.5962}

# {'neg': 0.688, 'neu': 0.312, 'pos': 0.0, 'compound': -0.765}TextBlob情感分析:

一個類似的工具是用於情感分析的TextBlob。TextBlob實際上是一個多功能的庫,類似於NLTK和SpaCy。在情感分析工具上,它與VADER在報告情感極性和主觀性方面都有所不同。從我個人的經驗來看,我更喜歡VADER,但每個人都有自己的長處和短處。TextBlob也非常容易實現:

from textblob import TextBlob

testimonial = TextBlob("This class is my favorite!!!")

print(testimonial.sentiment)

testimonial = TextBlob("I hate this class :(")

print(testimonial.sentiment)

# 輸出

# Sentiment(polarity=0.9765625, subjectivity=1.0)

# Sentiment(polarity=-0.775, subjectivity=0.95)注意:基於模式的模型在上面的例子中不能很好地處理這樣的小文字。我建議對平均四句話的文字進行情感分析。要快速演示這一點,請參閱Jupyter Notebook:https://github.com/avgupta456/medium_nlp/blob/master/Sentiment.ipynb

其他應用

這裡有幾個附加的主題和一些有用的演演算法和工具來加速你的開發。

- 關鍵詞提取:命名實體識別(NER)使用SpaCy,快速自動關鍵字提取(RAKE)使用ntlk-rake

- 文字摘要:TextRank(類似於PageRank)使用PyTextRank SpaCy擴充套件,TF-IDF使用GenSim

- 拼寫檢查:PyEnchant,SymSpell Python埠

希望這些範例有助於演示Python中可用於自然語言處理的大量資源。不管問題是什麼,有人開發了一個庫來簡化流程。使用這些庫可以在短時間內產生很好的結果。

提示和技巧

通過對NLP的介紹、Python庫的概述以及一些範例應用程式,你幾乎可以應對自己的挑戰了。最後,我有一些技巧和技巧來充分利用這些資源。

- Python工具:我推薦Poetry 用於依賴關係管理,Jupyter Notebook用於測試新模型,Black和/或Flake8用於保持程式碼風格,GitHub用於版本管理。

- 保持條理:從一個庫跳到另一個庫,複製程式碼到當前你編寫的程式碼測試雖然很容易實現,但是不好。我建議採取你採取合適的更慎重的方法,因為你不想在匆忙中錯過一個好的解決方案。

- 預處理:垃圾進,垃圾出。實現一個強大的預處理管道來清理輸入非常重要。目視檢查處理後的文字,以確保所有內容都按預期工作。

- 展示結果:選擇如何展示你的結果會有很大的不同。如果輸出的文字看起來有點粗糙,可以考慮顯示聚合統計資訊或數值結果。

原文連結:https://towardsdatascience.com/natural-language-processing-nlp-dont-reinvent-the-wheel-8cf3204383dd

歡迎關注磐創AI部落格站: http://panchuang.net/

sklearn機器學習中文官方檔案: http://sklearn123.com/

歡迎關注磐創部落格資源彙總站: http://docs.panchuang.net/