人工智慧中的文字分類:技術突破與實戰指導

在本文中,我們全面探討了文字分類技術的發展歷程、基本原理、關鍵技術、深度學習的應用,以及從RNN到Transformer的技術演進。文章詳細介紹了各種模型的原理和實戰應用,旨在提供對文字分類技術深入理解的全面視角。

關注TechLead,分享AI全維度知識。作者擁有10+年網際網路服務架構、AI產品研發經驗、團隊管理經驗,同濟本復旦碩,復旦機器人智慧實驗室成員,阿里雲認證的資深架構師,專案管理專業人士,上億營收AI產品研發負責人。

一、引言

文字分類作為人工智慧領域的一個重要分支,其價值和影響力已經深入到我們日常生活的各個角落。在這個資料驅動的時代,文字分類不僅是機器學習和深度學習技術的集中展示,更是智慧化應用的基礎。

文字分類的重要性

文字分類的核心是將文字資料按照其含義或屬性分配到預定義的類別中。這聽起來簡單,但在實際操作中卻極具挑戰性。為什麼文字分類如此重要?其實,無論是個人使用者還是大型企業,我們都在日常生活中與海量的文字資料打交道。例如,電子郵件自動分類系統可以幫助我們區分垃圾郵件和重要郵件,社交媒體平臺利用文字分類來過濾不恰當的內容,而在商業智慧中,文字分類幫助企業從客戶反饋中提取有價值的洞察。

技術發展歷程

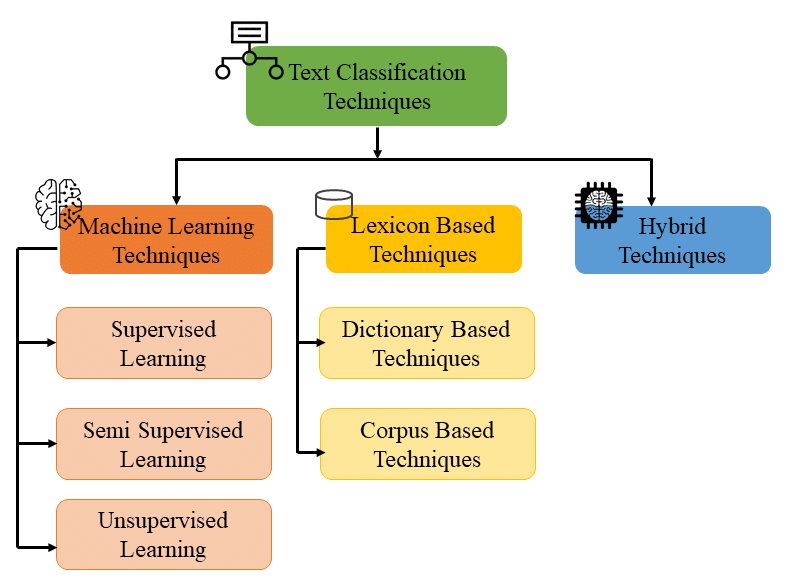

文字分類技術的發展經歷了從簡單的基於規則的方法到複雜的機器學習演演算法,再到今天的深度學習模型的演變。在早期,文字分類依賴於專家系統和簡單的統計方法,但這些方法往往受限於規模和靈活性。隨著機器學習的發展,尤其是支援向量機(SVM)和隨機森林等演演算法的應用,文字分類的準確性和適應性有了顯著提高。進入深度學習時代,折積神經網路(CNN)和迴圈神經網路(RNN)等模型極大地提高了文字分類的效能,特別是在處理大規模和複雜的資料集時。

現代應用範例

在現代應用中,文字分類技術已成為許多行業不可或缺的部分。例如,在金融領域,文字分類被用於分析市場趨勢和預測股市動態。金融分析師依賴於演演算法從新聞報道、社交媒體貼文和財報中提取關鍵資訊,以做出更明智的投資決策。此外,醫療保健行業也在利用文字分類技術來處理病歷報告,自動識別疾病模式和病人需求,從而提高診斷的準確性和效率。

通過這些例子,我們可以看到,文字分類不僅是技術的展示,更是現代社會運作和發展的關鍵部分。隨著技術的不斷進步和應用領域的不斷拓展,文字分類的重要性和影響力只會繼續增長。

二、文字分類基礎

文字分類是人工智慧和自然語言處理(NLP)領域的一個核心任務,涉及到理解和處理自然語言文字,將其分類到預定義的類別中。這一任務的基礎是理解文字的含義,並據此做出決策。

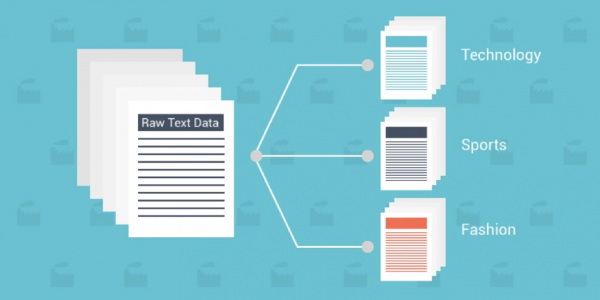

文字分類的定義和目的

簡單來說,文字分類是將文字資料(如檔案、郵件、網頁內容等)自動分配到一個或多個預定義類別的過程。這個過程的目的在於簡化資訊處理,提高資料組織和檢索的效率,以及支援更復雜的資訊處理任務,如情感分析或主題識別。

文字分類的關鍵要素

1. 預處理

- 重要性:預處理是文字分類的首要步驟,涉及清洗和準備原始文字資料。

- 方法:包括去除噪音(如特殊字元、無關資訊)、詞幹提取、分詞等。

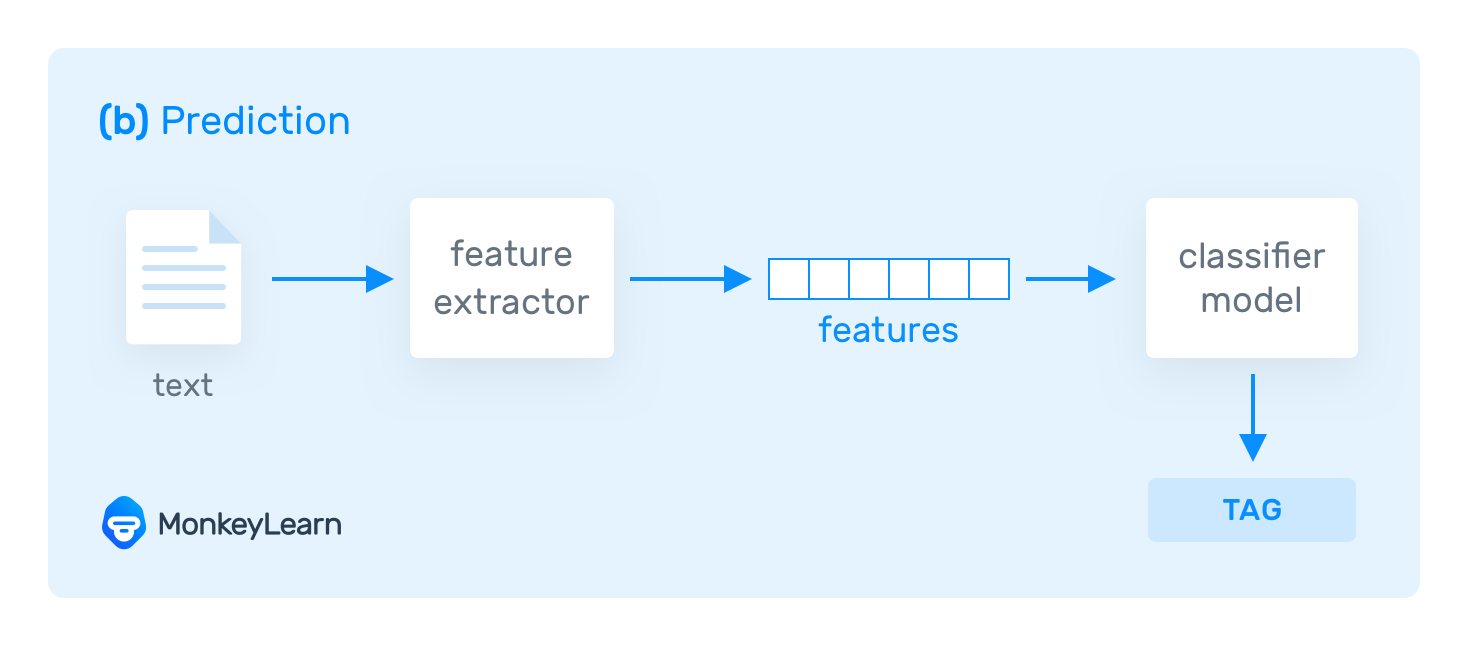

2. 特徵提取

- 概念:將文字轉化為機器可理解的形式,通常是數值向量。

- 技術:傳統方法如詞袋模型(Bag of Words)和TF-IDF,以及現代方法如詞嵌入(Word Embeddings)。

3. 分類演演算法

- 多樣性:文字分類可採用多種機器學習演演算法,包括樸素貝葉斯、決策樹、支援向量機等。

- 發展:深度學習方法如折積神經網路(CNN)和迴圈神經網路(RNN)為文字分類帶來了革命性的改進。

文字分類的應用領域

文字分類廣泛應用於多個領域,包括:

- 垃圾郵件檢測:自動識別並過濾垃圾郵件。

- 情感分析:從使用者評論中提取情感傾向,廣泛應用於市場分析和社交媒體監控。

- 主題分類:自動識別文章或檔案的主題,用於新聞聚合、內容推薦等。

挑戰和考量

文字分類雖然技術成熟,但仍面臨一些挑戰:

- 語言多樣性和複雜性:不同語言和文化背景下的文書處理需要特定的適應和處理策略。

- 資料不平衡和偏見:訓練資料的質量直接影響分類效能,需要注意資料偏見和不平衡問題。

- 實時性和可延伸性:在處理大量實時資料時,演演算法的效率和擴充套件性變得尤為重要。

在本章中,我們對文字分類的基礎進行了全面的介紹,從定義和目的到關鍵技術和挑戰,為深入理解文字分類的技術細節和實際應用打下了堅實的基礎。

三、關鍵技術和模型

在深入探討文字分類的關鍵技術和模型時,我們會涉及從傳統的機器學習方法到現代的深度學習技術。每種技術都有其獨特之處,並在特定的應用場景下表現出色。在這一部分,我們將通過一些關鍵程式碼段來展示這些模型的實現和應用。

傳統機器學習方法

樸素貝葉斯分類器

樸素貝葉斯是一種基於概率的簡單分類器,廣泛用於文字分類。以下是使用Python和scikit-learn實現的一個簡單例子:

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.pipeline import Pipeline

# 建立一個文字分類管道

text_clf_nb = Pipeline([

('vect', CountVectorizer()),

('clf', MultinomialNB()),

])

# 範例資料

train_texts = ["This is a good book", "This is a bad movie"]

train_labels = [0, 1] # 0代表正面,1代表負面

# 訓練模型

text_clf_nb.fit(train_texts, train_labels)

支援向量機(SVM)

支援向量機(SVM)是另一種常用的文字分類方法,特別適用於高維資料。以下是使用SVM的範例程式碼:

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.svm import SVC

from sklearn.pipeline import Pipeline

# 建立一個文字分類管道

text_clf_svm = Pipeline([

('tfidf', TfidfVectorizer()),

('clf', SVC(kernel='linear')),

])

# 訓練模型

text_clf_svm.fit(train_texts, train_labels)

深度學習方法

折積神經網路(CNN)

折積神經網路(CNN)在影象處理領域表現突出,也被成功應用於文字分類。以下是使用PyTorch實現文字分類的CNN模型的簡單例子:

import torch

import torch.nn as nn

import torch.nn.functional as F

class TextCNN(nn.Module):

def __init__(self, vocab_size, embed_dim, num_classes):

super(TextCNN, self).__init__()

self.embedding = nn.Embedding(vocab_size, embed_dim)

self.conv = nn.Conv2d(1, 100, (3, embed_dim))

self.fc = nn.Linear(100, num_classes)

def forward(self, x):

x = self.embedding(x) # Embedding layer

x = x.unsqueeze(1) # Add channel dimension

x = F.relu(self.conv(x)).squeeze(3) # Convolution layer

x = F.max_pool1d(x, x.size(2)).squeeze(2) # Max pooling

x = self.fc(x) # Fully connected layer

return x

# 範例網路建立

vocab_size = 1000 # 詞彙表大小

embed_dim = 100 # 嵌入層維度

num_classes = 2 # 類別數

model = TextCNN(vocab_size, embed_dim, num_classes)

迴圈神經網路(RNN)和LSTM

迴圈神經網路(RNN)及其變體LSTM(長短期記憶網路)在處理序列資料,如文字,方面非常有效。以下是使用PyTorch實現RNN的範例:

class TextRNN(nn.Module):

def __init__(self, vocab_size, embed_dim, hidden_dim, num_classes):

super(TextRNN, self).__init__()

self.embedding = nn.Embedding(vocab_size, embed_dim)

self.rnn = nn.RNN(embed_dim, hidden_dim, batch_first=True)

self.fc = nn.Linear(hidden_dim, num_classes)

def forward(self, x):

x = self.embedding(x)

x, _ = self.rnn(x) # RNN layer

x = x[:, -1, :] # 獲取序列的最後一個時間步的輸出

x = self.fc(x)

return x

# 範例網路

建立

hidden_dim = 128 # 隱藏層維度

model = TextRNN(vocab_size, embed_dim, hidden_dim, num_classes)

這些程式碼段展示了不同文字分類技術的實現,從簡單的機器學習模型到複雜的深度學習網路。在接下來的章節中,我們將進一步探討這些模型的應用案例和效能評估。

四、深度學習在文字分類中的應用

深度學習技術已成為文字分類領域的重要推動力,為處理自然語言帶來了前所未有的效果。在這一部分,我們將探討深度學習在文字分類中的幾種關鍵應用,並通過範例程式碼展示這些模型的實現。

折積神經網路(CNN)的應用

CNN在文字分類中的應用,主要是利用其在提取區域性特徵方面的優勢。以下是用PyTorch實現的一個簡單的文字分類CNN模型:

import torch

import torch.nn as nn

import torch.nn.functional as F

class TextCNN(nn.Module):

def __init__(self, vocab_size, embed_dim, num_classes):

super(TextCNN, self).__init__()

self.embedding = nn.Embedding(vocab_size, embed_dim)

self.conv1 = nn.Conv2d(1, 100, (3, embed_dim))

self.conv2 = nn.Conv2d(1, 100, (4, embed_dim))

self.conv3 = nn.Conv2d(1, 100, (5, embed_dim))

self.fc = nn.Linear(300, num_classes)

def forward(self, x):

x = self.embedding(x).unsqueeze(1) # 增加一個維度表示通道

x1 = F.relu(self.conv1(x)).squeeze(3)

x1 = F.max_pool1d(x1, x1.size(2)).squeeze(2)

x2 = F.relu(self.conv2(x)).squeeze(3)

x2 = F.max_pool1d(x2, x2.size(2)).squeeze(2)

x3 = F.relu(self.conv3(x)).squeeze(3)

x3 = F.max_pool1d(x3, x3.size(2)).squeeze(2)

x = torch.cat((x1, x2, x3), 1) # 合併特徵

x = self.fc(x)

return x

# 範例網路建立

vocab_size = 1000

embed_dim = 100

num_classes = 2

model = TextCNN(vocab_size, embed_dim, num_classes)

迴圈神經網路(RNN)和LSTM

RNN和LSTM在處理文字序列時表現出色,特別是在理解長文字和上下文資訊方面。以下是使用PyTorch實現的LSTM模型:

class TextLSTM(nn.Module):

def __init__(self, vocab_size, embed_dim, hidden_dim, num_classes):

super(TextLSTM, self).__init__()

self.embedding = nn.Embedding(vocab_size, embed_dim)

self.lstm = nn.LSTM(embed_dim, hidden_dim, batch_first=True)

self.fc = nn.Linear(hidden_dim, num_classes)

def forward(self, x):

x = self.embedding(x)

x, _ = self.lstm(x) # LSTM layer

x = x[:, -1, :] # 獲取序列最後一個時間步的輸出

x = self.fc(x)

return x

# 範例網路建立

hidden_dim = 128

model = TextLSTM(vocab_size, embed_dim, hidden_dim, num_classes)

Transformer和BERT

Transformer模型,特別是BERT(Bidirectional Encoder Representations from Transformers),已經成為NLP領域的一個重要里程碑。BERT通過預訓練和微調的方式,在多種文字分類任務上取得了革命性的進展。以下是使用Hugging Face的Transformers庫來載入預訓練的BERT模型並進行微調的程式碼:

from transformers import BertTokenizer, BertForSequenceClassification

import torch

# 載入預訓練模型和分詞器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased', num_labels=num_classes)

# 範例文字

texts = ["This is a good book", "This is a bad movie"]

inputs = tokenizer(texts, padding=True, truncation=True, return_tensors="pt")

# 微調模型

outputs = model(**inputs)

在這一章節中,我們展示了深度學習在文字分類中的幾種關鍵應用,包括CNN、RNN、LSTM和Transformer模型。這些模型的程式碼實現為我們提供了一個實際操作的視角,幫助我們理解它們在文字分類任務中的作用和效果。

五、PyTorch實戰:文字分類

在這一章節中,我們將通過一個具體的例子,展示如何使用PyTorch框架實現文字分類任務。我們將構建一個簡單的深度學習模型,用於區分文字的情感傾向,即將文字分類為正面或負面。

場景描述

我們的目標是建立一個文字分類模型,能夠根據使用者評論的內容,自動判斷其為正面或負面評價。這種型別的模型在各種線上平臺,如電子商務網站、電影評價網站中都有廣泛應用。

輸入和輸出

- 輸入:使用者的文字評論。

- 輸出:二元分類結果,即正面(positive)或負面(negative)。

處理過程

1. 資料預處理

首先,我們需要對文字資料進行預處理,包括分詞、去除停用詞、轉換為小寫等,然後將文字轉換為數位表示(詞嵌入)。

2. 構建模型

我們將使用一個基於LSTM的神經網路模型,它能有效地處理文字資料的序列特性。

3. 訓練模型

使用標記好的資料集來訓練我們的模型,通過調整引數優化模型效能。

4. 評估模型

在獨立的測試集上評估模型效能,確保其準確性和泛化能力。

完整的PyTorch實現程式碼

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, Dataset

import torch.nn.functional as F

# 範例資料集

class TextDataset(Dataset):

def __init__(self, texts, labels):

self.texts = texts

self.labels = labels

def __len__(self):

return len(self.texts)

def __getitem__(self, idx):

return self.texts[idx], self.labels[idx]

# 文字分類模型

class TextClassifier(nn.Module):

def __init__(self, vocab_size, embed_dim, hidden_dim, num_classes):

super(TextClassifier, self).__init__()

self.embedding = nn.Embedding(vocab_size, embed_dim)

self.lstm = nn.LSTM(embed_dim, hidden_dim, batch_first=True)

self.fc = nn.Linear(hidden_dim, num_classes)

def forward(self, x):

x = self.embedding(x)

x, _ = self.lstm(x)

x = x[:, -1, :]

x = self.fc(x)

return x

# 引數設定

vocab_size = 10000 # 詞彙表大小

embed_dim = 100 # 嵌入維度

hidden_dim = 128 # LSTM隱藏層維度

num_classes = 2 # 類別數(正面/負面)

batch_size = 64 # 批次處理大小

learning_rate = 0.001 # 學習率

# 資料準備

train_dataset = TextDataset([...], [...]) # 訓練資料集

test_dataset = TextDataset([...], [...]) # 測試資料集

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True)

test_loader = DataLoader(test_dataset, batch_size=batch_size, shuffle=False)

# 初始化模型

model = TextClassifier(vocab_size, embed_dim, hidden_dim, num_classes)

optimizer = optim.Adam(model.parameters(), lr=learning_rate)

# 訓練過程

for epoch in range(num_epochs):

for texts, labels in train_loader:

outputs = model(texts)

loss = F.cross_entropy(outputs, labels)

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 測試過程

correct = 0

total = 0

with torch.no_grad():

for texts, labels in test_loader:

outputs = model(texts)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f'Accuracy of the model on the test texts: {100 * correct / total}%')

六、總結

在本文中,我們對文字分類技術進行了全面的探討,從其基本原理到高階應用,從傳統機器學習方法到最新的深度學習技術。我們的目的是為讀者提供一個從基礎到前沿的知識架構,幫助他們深入理解文字分類在人工智慧領域的重要地位和發展趨勢。

-

技術融合的重要性:文字分類的進步不僅僅源於單一技術的突破,而是多種技術的融合與創新。例如,深度學習的興起給傳統的文字分類方法帶來了新的生命力,而最新的模型如Transformer則是自然語言處理領域的一個重大革命。

-

資料的核心作用:無論技術多麼先進,高質量的資料始終是文字分類成功的關鍵。資料的準備、預處理和增強對於構建高效、準確的模型至關重要。

-

模型的可解釋性與道德責任:隨著文字分類技術的廣泛應用,模型的可解釋性和道德責任成為了不可忽視的話題。如何確保模型的決策公平、透明,並考慮到潛在的倫理影響,是我們未來需要深入探討的問題。

-

持續的技術革新:文字分類領域持續經歷著快速的技術革新。從最初的基於規則的系統,到現在的基於深度學習的模型,技術的進步推動了文字分類應用的邊界不斷擴充套件。

-

實踐與理論的結合:理論知識和實際應用的結合是理解和掌握文字分類技術的關鍵。通過實戰案例,我們能更深刻地理解理論,並在實際問題中找到合適的解決方案。

在文字分類的未來發展中,我們預計將看到更多的技術創新和應用探索。這不僅會推動人工智慧領域的進步,也將在更廣泛的領域產生深遠的影響。我們期待看到這些技術如何在不同的行業中發揮作用,同時也關注它們如何更好地服務於社會和個人。

關注TechLead,分享AI全維度知識。作者擁有10+年網際網路服務架構、AI產品研發經驗、團隊管理經驗,同濟本復旦碩,復旦機器人智慧實驗室成員,阿里雲認證的資深架構師,專案管理專業人士,上億營收AI產品研發負責人。

如有幫助,請多關注

TeahLead KrisChang,10+年的網際網路和人工智慧從業經驗,10年+技術和業務團隊管理經驗,同濟軟體工程本科,復旦工程管理碩士,阿里雲認證雲服務資深架構師,上億營收AI產品業務負責人。